自变量的筛选方法

在多重线性回归的实际应用中,研究者根据相关专业知识和研究经验收集与因变量y可能有关的自变量信息,由于不清楚变量间的真实联系同时又担心可能会遗漏对因变量y有重要作用的自变量,所以回归模型最初的自变量数量通常很多。但是这些自变量间可能相互有联系,同时其中某些自变量可能和因变量y间不具有线性关系,若把它们都引入回归方程,不但回归模型复杂,模型计算量大,而且会降低回归参数估计和预测的精度。另一方面,如果遗漏了对因变量有重要作用的自变量,回归模型的效果自然也不好。所以回归模型应尽可能包含对因变量有较大贡献的自变量,同时也要尽可能保证模型中自变量的数目尽可能少,将贡献不大或没有贡献的自变量应排除在回归模型之外,该过程称为自变量筛选,由筛选出的自变量建立的回归方程称为最优回归方程。

(一)自变量选择准则

1. 残差平方和减小或决定系数增大 若某一自变量被引入模型后SS残差减小很多,说明该变量对反映变量y的作用大,可被引入;反之,说明其对y的作用小,不应该被引入。

残差平方和SS残差减小与决定系数R2增大完全等价。需要说明的是随回归模型中自变量个数的增加SS残差总是在减少,决定系数R2总是在增大,故SS残差减小准则只适用于自变量个数相同的模型间的比较。

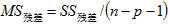

2. 残差均方减小或调整决定系数增大 由于在回归模型中的自变量个数越多,残差平方和就越小,R2的值也越大,而增加的自变量可能对因变量贡献很小。采用残差均方则可消除了自变量个数的影响, ,若增加自变量而使残差平方和的减少被自由度的减少所抵消,则残差均方不会减小。

,若增加自变量而使残差平方和的减少被自由度的减少所抵消,则残差均方不会减小。

调整决定系数 (adjusted R-square),记为R2adj。

其中,n为样本含量,p为引入回归模型的自变量个数,R2为决定系数。

调整决定系数 越大越好则

越大越好则 越小越好,两者等价。

越小越好,两者等价。

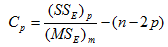

3.Mallow’s Cp选择法 Mallow’s Cp也可以用来评价回归模型,其计算公式为:

式中p为方程中包含的自变量个数,(SSE)p为包含p个自变量的回归方程所对应的残差平方和,(MSE)m为包含所有m个自变量的回归方程(该模型称为全模型)对应的残差均方。

该方法就是选择Cp最接近于p的回归方程为最优方程。

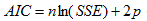

4.AIC信息准则 AIC即赤池信息量,由日本统计学家赤池提出。AIC越小,模型越优,可以比较变量数不同的模型。

对于线性回归模型其计算公式是

式中p为方程中包含的自变量个数,SSE为包含p个自变量的回归方程所对应的残差平方和,n为样本量。

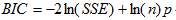

5.BIC信息准则 BIC即贝叶斯信息量,由统计学家Gideon E. Schwarz提出,所以也称SBC或者SBIC。BIC和AIC类似,BIC越小,模型越优,可以比较变量数不同的模型。

对于线性回归模型其计算公式是

式中p为方程中包含的自变量个数,SSE为包含p个自变量的回归方程所对应的残差平方和,n为样本量。

(二)自变量的选择方法

1. 最优子集法 对于含有p个自变量的回归建模,所有可能的自变量子集回归模型有 个。根据某种模型“最优”的判断准则,从中选择一个或几个“最优”回归模型,称为最优子集法,也称全局择优法。该方法可选出固定自变量个数时的最优回归方程。缺点是计算量较大,一般适用于自变量个数不太多的情形。

个。根据某种模型“最优”的判断准则,从中选择一个或几个“最优”回归模型,称为最优子集法,也称全局择优法。该方法可选出固定自变量个数时的最优回归方程。缺点是计算量较大,一般适用于自变量个数不太多的情形。

的作用大小一般常用偏回归平方和及偏F检验来判断,但也可以采用模型评优的方法来确定,比如采用AIC准则。

的作用大小一般常用偏回归平方和及偏F检验来判断,但也可以采用模型评优的方法来确定,比如采用AIC准则。

局部择优法具体有以下三种筛选模式,分别是前进法,后退法和逐步法。

(1)前进法:回归模型中的自变量从无到有,依次逐一选入有意义的自变量进入模型。首先确定纳入标准;每一个自变量按此标准逐一引入回归方程;首先选入最有意义的自变量,直到没有自变量可选为止。该方法可以剔除高度相关的自变量。它的局限性在于纳入标准取值严格时,可能没有一个自变量能选入;纳入标准较宽松时,开始选入的自变量在新的变量选入后又不再进行检验,因而模型中可能包含无意义的自变量。采用偏F检验作为选入标准时,若某变量的 ,则选入,一般α=0.15。

,则选入,一般α=0.15。

(2)后退法:回归模型中首先包含所有的自变量,然后逐一剔除无意义的自变量。首先确定剔除标准;每一个自变量按此标准逐一从回归模型中剔除;首先剔除最没有意义的自变量,直到没有自变量可剔除为止。后退法的局限在于剔除标准较大时,任何一个自变量都不能被剔除;剔除标准较小时,开始被剔除的自变量后来在新条件下即使变得对因变量有较大的贡献,也不能再次被选入回归模型并参与检验。采用偏F检验作为选入标准时,若某变量的 ,则剔除,一般α=0.15。

,则剔除,一般α=0.15。

,则选入;若某变量的

,则选入;若某变量的 ,则剔除,一般

,则剔除,一般 ,通常α选入=α剔除=0.15。

,通常α选入=α剔除=0.15。